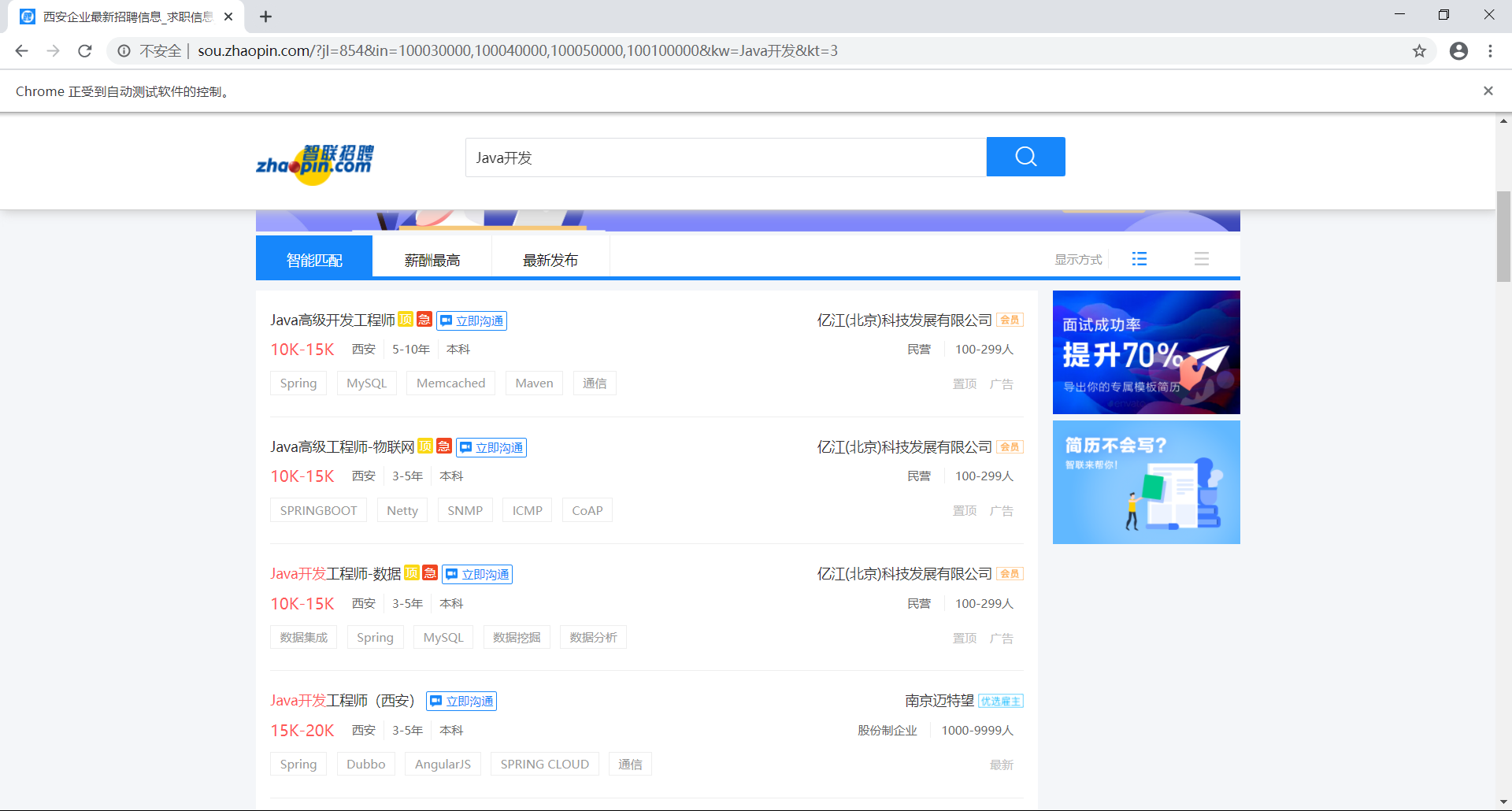

scrapy+selenium爬取智联招聘

这是第三个大四综合实践——数据处理与分析。我们小组打算爬取各个招聘网站进行数据分析。

我负责其中的爬虫模块,教了两个队友怎么使用scrapy,打算我解决完爬取数据的一些难题之后,剩余的解析就交给他们。

我觉得解析数据只是苦力活,只要爬取到带有数据的html,剩下的就很轻松了。最后我选择使用selenium,这样就不用分析接口了,两个刚学爬虫的队友也能轻松搞定。

很快地搞定了前程无忧网和拉勾网之后,我在爬取智联招聘网遇到了很多问题。本文将这些问题以及解决方案记录下来,供读者参考。